爬取不外乎分为四个大的步骤:

发起请求:通过HTTP库向目标站点发起请求,即发送一个Requests,请求可以包含额外的headers等信息,等待服务器响应。

解析内容:得到的内容可能是HTML,可以用正则表达式、网页解析库进行解析,可以是Json,可以直接转化为Json,可能是二进制数据,可以做保存或进一步处理。

获取响应内容:如果服务器能正常响应,会得到一个Response,Response的内容便是所要获取的页面内容,类型可能是HTML,Json字符串等,二进制数据(图片视频)等。

保存数据:保存形式多样,可以存为文本,也可以保存至数据库或者保存特定格式的文件。

说了这么多乱七八糟的,言归正传,我们这次利用requests库和正则表达式来抓取相关内容

要开始啦:

首先确定已经安装好了requests库

现在我们开始进行抓取前的分析:

我们需要抓取的目标站点是:https://maoyan.com/board/4,页面如下

将网页滚动到最下方,可以发现这个不止一页,所以现在我们点击第二页,看URL和内容都进行了变化

可以发现此时页面的URL变为https://maoyan.com/board/4?offset=10,比之前的URL多了一个参数offset=10,目前显示11~20名的电影,再点击下一页,发现URL变成 https://maoyan.com/board/4?offset=20,offset变成了20,目前显示21~30的电影。

总结规律,offest代表偏移量值,如果偏移量(内存中存储数据的方式是:一个存储数据的“实际地址”=段首地址+偏移量)为n,则电影序号就是n+1~n+10,每页显示10 个。所以我们想要获取100个,需要分开10次请求,10次每次的offest参数分别设置为0、10、20、30、40、50、60、70、80、90。

当当当当~抓取首页了

首先抓取第一页的内容,我们实现了get_one_page()方法,给他传入url参数,然后将抓取的页面结果返回,再通过main()方法调用。headers根据自己实际情况

<!—hexoPostRenderEscape:

import requestsdef get_one_page(url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.170 Safari/537.36',

}

response = requests.get(url,headers=headers)

if response.status_code == 200:

return response.text

return None

def main():

url = 'https://maoyan.com/board/4'

html = get_one_page(url)

print(html)

main()</code></pre>:hexoPostRenderEscape—>

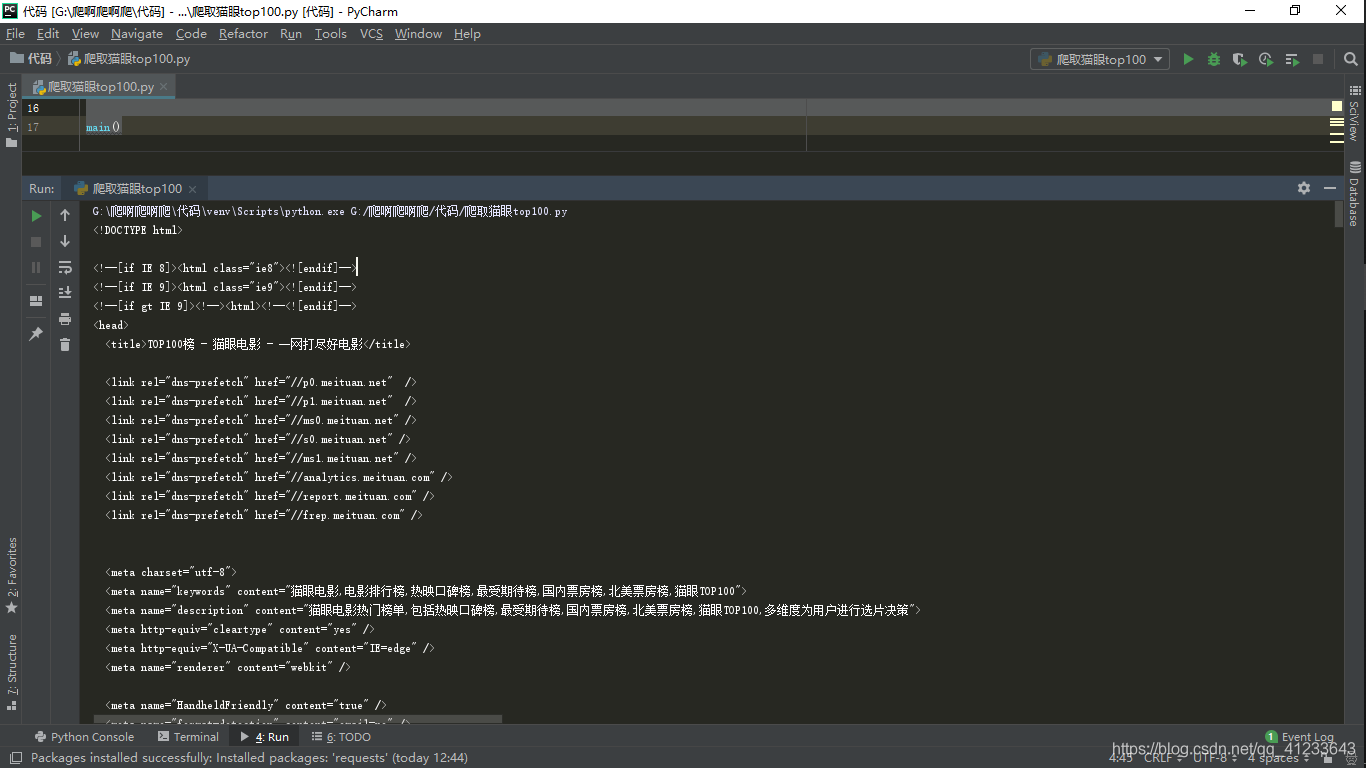

下图为源码:一部分,哈哈哈哈哈

我们回到网页看源代码:我们可以看到一部电影的源代码是一个dd节点,我们用正则表达式来提取里面的一些电影信息。

首先提取排名信息。他的排名信息是在class为board-index的i节点内,这里利用非贪婪匹配来提取i节点内的信息,正则表达式写为:

<dd>.*?board-index.*?>(.*?)</i>接下来提取电影图片,可以看到后面有a节点,其内部有两个img节点。经过检查发现,第二个img节点的data-src属性是图片链接。这里提取第二个img节点的data-src属性,正则表达式可以写为

<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)"再往后需要提取电影的名称,他在后面的p节点内,class为name。所以,可以用name做一个标志位,然后进一步提取到其内a节点的正文内容,此时正则表达式改写如下:

<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?name.*?a.*?>(.*?)</a>在提取主演、发布时间/评分等,原理一样,正则表达式如下:

<!—hexoPostRenderEscape:

<dd>.?board-index.?>(.?)</i>.?data-src="(.?)".?name.?a.?>(.?)</a>.?star.?>(.?)</p>.?releasetime.?>(>*?)</p>.?integer.?>(.?)</i>.?fraction.?>(.?)</i>.*?</dd></code></pre>:hexoPostRenderEscape—>

这样一个正则表达式就可以匹配一个电影的结果,里面匹配了7个信息,通过调用findall()方法提取出所有内容。

代码如下:

def parse_one_page(html):

pattern = re.compile(

'<dd>.*?board-index.*?>(\d+)</i>.*?data-src="(.*?)".*?name"><a'

+ '.*?>(.*?)</a>.*?star">(.*?)</p>.*?releasetime">(.*?)</p>'

+ '.*?integer">(.*?)</i>.*?fraction">(.*?)</i>.*?</dd>',

re.S)

items = re.findall(pattern,html)

print(items)

通过以上我们可以提取一页的10个电影信息,但是数据会很乱,我们需要再进行处理:

<!—hexoPostRenderEscape:

def parse_one_page(html):

pattern = re.compile('<dd>.?board-index.?>(\d+)</i>.?data-src="(.?)".*?name"><a' + '.*?>(.*?)</a>.*?star">(.*?)</p>.*?releasetime">(.*?)</p>'

+ '.*?integer">(.*?)</i>.*?fraction">(.*?)</i>.*?</dd>', re.S)

items = re.findall(pattern, html)

for item in items:

yield {

'index': item[0],

'image': item[1],

'title': item[2],

'actor': item[3].strip()[3:],

'time': item[4].strip()[5:],

'score': item[5] + item[6]

}</code></pre>:hexoPostRenderEscape-->

接下来进行写入文件:

我们在这里直接写入到一个文本文件。这里通过Json库的dumps()方法实现字典的序列化,并指定ensure_ascii参数为False,这样保证输出结果是中文形式而不是Unicode编码。代码:

def write_to_file(content):

with open('result.txt', 'a', encoding='utf-8') as f:

f.write(json.dumps(content, ensure_ascii=False) + '\n')通过write_to_file()即可将字典写入到文本文件。此处的content参数就是一个电影的提取结果,是一个字典。

整合代码啦~终于要结束了

最后用main() 函数调用前面的方法,将单页电影结果写入文件

代码:

<!—hexoPostRenderEscape:

def main():

url = 'http://maoyan.com/board/4'

html = get_one_page(url)

for item in parse_one_page(html): write_to_file(item)</code></pre>:hexoPostRenderEscape-->

但现在我们完成了10部电影的提取。我们需要top100的电影,所以还需要遍历一下,给链接传入offset参数,将其他90部电影爬取,要添加一下:

if __name__ == '__main__':

for i in range(10):

main(offset=i * 10)我们还需要把main()函数改一下,接受一个offest值作为偏移量,然后构造URL进行爬取。代码:

def main(offset):

url = 'http://maoyan.com/board/4?offset=' + str(offset)

html = get_one_page(url)

for item in parse_one_page(html):

print(item)

write_to_file(item)完整代码:

import json

import requests

from requests.exceptions import RequestException

import re

import time

def get_one_page(url):

try:

headers = {

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.162 Safari/537.36'

}

response = requests.get(url, headers=headers)

if response.status_code == 200:

return response.text

return None

except RequestException:

return None

def parse_one_page(html):

pattern = re.compile('<dd>.*?board-index.*?>(\d+)</i>.*?data-src="(.*?)".*?name"><a'

+ '.*?>(.*?)</a>.*?star">(.*?)</p>.*?releasetime">(.*?)</p>'

+ '.*?integer">(.*?)</i>.*?fraction">(.*?)</i>.*?</dd>', re.S)

items = re.findall(pattern, html)

for item in items:

yield {

'index': item[0],

'image': item[1],

'title': item[2],

'actor': item[3].strip()[3:],

'time': item[4].strip()[5:],

'score': item[5] + item[6]

}

def write_to_file(content):

with open('result.txt', 'a', encoding='utf-8') as f:

f.write(json.dumps(content, ensure_ascii=False) + '\n')

def main(offset):

url = 'http://maoyan.com/board/4?offset=' + str(offset)

html = get_one_page(url)

for item in parse_one_page(html):

print(item)

write_to_file(item)

if __name__ == '__main__':

for i in range(10):

main(offset=i * 10)

time.sleep(1)延时等待

猫眼已经增加了反爬虫~如果速度过快则无响应,所以最后加了一个延时等待

运行结果:(只截取一部分~~)

文本文件:(截取一部分)

So~~~此时此刻全部完成了

撒花撒花撒花~~

自己的一些看法总结,有错误请大神们指出。